Mes: diciembre 2013

UNIDAD III: Internet

EstándarInternet

Internet es un conjunto descentralizado de redes de comunicación interconectadas que utilizan la familia de protocolos TCP/IP, lo cual garantiza que las redes físicas heterogéneas que la componen funcionen como una red lógica única, de alcance mundial. Sus orígenes se remontan a 1969, cuando se estableció la primera conexión de computadoras, conocida como Arpanet, entre tres universidades en California y una en Utah, Estados Unidos.

Uno de los servicios que más éxito ha tenido en Internet ha sido la World Wide Web (WWW o la Web), a tal punto que es habitual la confusión entre ambos términos. La WWW es un conjunto de protocolos que permite, de forma sencilla, la consulta remota de archivos de hipertexto. Esta fue un desarrollo posterior (1990) y utiliza Internet como medio de transmisión.

Existen, por tanto, muchos otros servicios y protocolos en Internet, aparte de la Web: el envío de correo electrónico (SMTP), la transmisión de archivos (FTP y P2P), las conversaciones en línea (IRC), la mensajería instantánea y presencia, la transmisión de contenido y comunicación multimedia —telefonía (VoIP), televisión (IPTV) —, los boletines electrónicos (NNTP), el acceso remoto a otros dispositivos (SSH y Telnet) o los juegos en línea.

El género de la palabra Internet es ambiguo, según el Diccionario de la lengua española de la Real Academia Española.

Historia

Sus orígenes se remontan a la década de 1960, dentro de ARPA (hoy DARPA), como respuesta a la necesidad de esta organización de buscar mejores maneras de usar los computadores de ese entonces, pero enfrentados al problema de que los principales investigadores y laboratorios deseaban tener sus propios computadores, lo que no sólo era más costoso, sino que provocaba una duplicación de esfuerzos y recursos.8 Así nace ARPANet (Advanced Research Projects Agency Network o Red de la Agencia para los Proyectos de Investigación Avanzada de los Estados Unidos), que nos legó el trazado de una red inicial de comunicaciones de alta velocidad a la cual fueron integrándose otras instituciones gubernamentales y redes académicas durante los años 70.

Investigadores, científicos, profesores y estudiantes se beneficiaron de la comunicación con otras instituciones y colegas en su rama, así como de la posibilidad de consultar la información disponible en otros centros académicos y de investigación. De igual manera, disfrutaron de la nueva habilidad para publicar y hacer disponible a otros la información generada en sus actividades.

En el mes de julio de 1961 Leonard Kleinrock publicó desde el MIT el primer documento sobre la teoría de conmutación de paquetes. Kleinrock convenció a Lawrence Roberts de la factibilidad teórica de las comunicaciones vía paquetes en lugar de circuitos, lo cual resultó ser un gran avance en el camino hacia el trabajo informático en red. El otro paso fundamental fue hacer dialogar a los ordenadores entre sí. Para explorar este terreno, en 1965, Roberts conectó una computadora TX2 en Massachusetts con un Q-32 en California a través de una línea telefónica conmutada de baja velocidad, creando así la primera (aunque reducida) red de computadoras de área amplia jamás construida.

- 1969: La primera red interconectada nace el 21 de noviembre de 1969, cuando se crea el primer enlace entre las universidades de UCLA y Stanford por medio de la línea telefónica conmutada, y gracias a los trabajos y estudios anteriores de varios científicos y organizaciones desde 1959 (ver: Arpanet). El mito de que ARPANET, la primera red, se construyó simplemente para sobrevivir a ataques nucleares sigue siendo muy popular. Sin embargo, este no fue el único motivo. Si bien es cierto que ARPANET fue diseñada para sobrevivir a fallos en la red, la verdadera razón para ello era que los nodos de conmutación eran poco fiables, tal y como se atestigua en la siguiente cita: “A raíz de un estudio de RAND, se extendió el falso rumor de que ARPANET fue diseñada para resistir un ataque nuclear. Esto nunca fue cierto, solamente un estudio de RAND, no relacionado con ARPANET, consideraba la guerra nuclear en la transmisión segura de comunicaciones de voz. Sin embargo, trabajos posteriores enfatizaron la robustez y capacidad de supervivencia de grandes porciones de las redes subyacentes. (Internet Society, A Brief History of the Internet)”

- 1972: Se realizó la Primera demostración pública de ARPANET, una nueva red de comunicaciones financiada por la DARPA que funcionaba de forma distribuida sobre la red telefónica conmutada. El éxito de ésta nueva arquitectura sirvió para que, en 1973, la DARPA iniciara un programa de investigación sobre posibles técnicas para interconectar redes (orientadas al tráfico de paquetes) de distintas clases. Para este fin, desarrollaron nuevos protocolos de comunicaciones que permitiesen este intercambio de información de forma «transparente» para las computadoras conectadas. De la filosofía del proyecto surgió el nombre de «Internet», que se aplicó al sistema de redes interconectadas mediante los protocolos TCP e IP.

- 1983: El 1 de enero, ARPANET cambió el protocolo NCP por TCP/IP. Ese mismo año, se creó el IAB con el fin de estandarizar el protocolo TCP/IP y de proporcionar recursos de investigación a Internet. Por otra parte, se centró la función de asignación de identificadores en la IANA que, más tarde, delegó parte de sus funciones en el Internet registry que, a su vez, proporciona servicios a los DNS.

- 1986: La NSF comenzó el desarrollo de NSFNET que se convirtió en la principal Red en árbol de Internet, complementada después con las redes NSINET y ESNET, todas ellas en Estados Unidos. Paralelamente, otras redes troncales en Europa, tanto públicas como comerciales, junto con las americanas formaban el esqueleto básico («backbone») de Internet.

- 1989: Con la integración de los protocolos OSI en la arquitectura de Internet, se inició la tendencia actual de permitir no sólo la interconexión de redes de estructuras dispares, sino también la de facilitar el uso de distintos protocolos de comunicaciones.

En el CERN de Ginebra, un grupo de físicos encabezado por Tim Berners-Lee creó el lenguaje HTML, basado en el SGML. En 1990 el mismo equipo construyó el primer cliente Web, llamado WorldWideWeb (WWW), y el primer servidor web.

A inicios de los 90, con la introducción de nuevas facilidades de interconexión y herramientas gráficas simples para el uso de la red, se inició el auge que actualmente le conocemos al Internet. Este crecimiento masivo trajo consigo el surgimiento de un nuevo perfil de usuarios, en su mayoría de personas comunes no ligadas a los sectores académicos, científicos y gubernamentales.18

Esto ponía en cuestionamiento la subvención del gobierno estadounidense al sostenimiento y la administración de la red, así como la prohibición existente al uso comercial del Internet. Los hechos se sucedieron rápidamente y para 1993 ya se había levantado la prohibición al uso comercial del Internet y definido la transición hacia un modelo de administración no gubernamental que permitiese, a su vez, la integración de redes y proveedores de acceso privados.

2006: El 3 de enero, Internet alcanzó los mil cien millones de usuarios. Se prevé que en diez años, la cantidad de navegantes de la Red aumentará a 2000 millones.

El resultado de todo esto es lo que experimentamos hoy en día: la transformación de lo que fue una enorme red de comunicaciones para uso gubernamental, planificada y construida con fondos estatales, que ha evolucionado en una miríada de redes privadas interconectadas entre sí. Actualmente la red experimenta cada día la integración de nuevas redes y usuarios, extendiendo su amplitud y dominio, al tiempo que surgen nuevos mercados, tecnologías, instituciones y empresas que aprovechan este nuevo medio, cuyo potencial apenas comenzamos a descubrir.

Navegadores

Un navegador o navegador web, conocido internacionalmente como browser, es un software que permite el acceso a Internet, interpretando la información de archivos y sitios web para que éstos puedan ser leídos.

La funcionalidad básica de un navegador web es permitir la visualización de documentos de texto, posiblemente con recursos multimedia incrustados. Además, permite visitar páginas web y hacer actividades en ella, es decir, podemos enlazar un sitio con otro, imprimir, enviar y recibir correo, entre otras funcionalidades más.

Los documentos que se muestran en un browser pueden estar ubicados en la computadora en donde está el usuario, pero también pueden estar en cualquier otro dispositivo que esté conectado en la computadora del usuario o a través de Internet, y que tenga los recursos necesarios para la transmisión de los documentos (un software servidor web).

Tales documentos, comúnmente denominados páginas web, poseen hipervínculos que enlazan una porción de texto o una imagen a otro documento, normalmente relacionado con el texto o la imagen.

El seguimiento de enlaces de una página a otra, ubicada en cualquier computadora conectada a Internet, se llama navegación, de donde se origina el nombre navegador (aplicado tanto para el programa como para la persona que lo utiliza, a la cual también se le llama cibernauta). Por otro lado, hojeador es una traducción literal del original en inglés, browser, aunque su uso es minoritario.

Tipos de navegadores

- Google Chrome

Fabricante: Google

Caracterisricas: freeware, diseño minimalista,un proceso por pestaña

Soporta HTML5:Si

- Internet Explorer

Fabricante: Microsoft

Caracterisricas: Viene por defecto con la instalación de Windows

Soporta HTML5: Sí

- Mozilla Firefox:

Fabricante: Mozilla

Caracterisricas: Viene por defecto con la instalación de Ubuntu

Soporta HTML5: Sí

- Safari:

Fabricante: Apple

Caracterisricas: Se instala junto con iTunes

Soporta HTML5: Sí

- Opera

Fabricante: Opera Software

Caracterisricas: Es bastante más ligero de lo normal en un navegador

Soporta HTML5: Sí

- Omniweb

Fabricante: Omnigroup

Caracterisricas: Se usa en MAC OS

Soporta HTML5: Sí

- Seamonkey

Fabricante: The SeaMonkey Council

Caracterisricas: Más que un navegador, es una suit que conforma un navegador, un editor web y un cliente de correo.

Soporta HTML5: Sí

- Chromiun

Fabricante: The Chromium Projects

Caracterisricas: Es un proyecto de navegador open source, basado en Google Chrome.

Soporta HTML5: Sí

- Skyfire

Fabricante: Skyfire Labs

Caracterisricas: Navegador para iOS. Soporta Flash (lo convierte en HTML5)

Soporta HTML5: Sí

- Maxthon

Fabricante: Maxton Asia

Caracterisricas: Utliza el motor WebKit, aunque tambien puede usar el motor Trident.

Soporta HTML5: Sí

- Avant

Fabricante: Avant Force

Caracterisricas: Soporta los motores Internet Explorer, Firefox y Chrome

Soporta HTML5: Sí

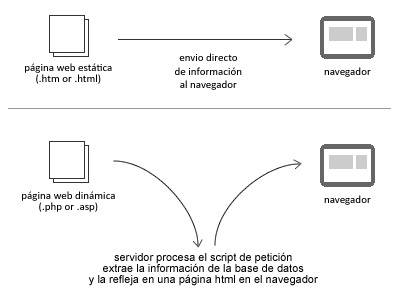

Páginas Web Estáticas

Los diseños web estáticos, son aquellos sitios que apuntan solo a mostrar información permanente sin que se pueda interactuar más allá de la navegación con la página web visitada. Este tipo de diseños web son incapaces de soportar aplicaciones web como gestores de base de datos, foros, chats on-line, etc.

Los diseños web estáticos son una excelente opción para aquellas empresas donde solo desean mostrar información acerca de su perfil comercial, como lo son: quiénes somos, dónde estamos, a qué nos dedicamos, nuestros servicios, etc.

La principal ventaja de este tipo de diseño web es ser altamente accesibles económicamente. Sin dejar de ser diseños fijos, cuentan con imágenes y textos, pero no necesitan de ningún tipo de programación especial.

Páginas Web Dinámicas

Estos tipos de diseños incluyen a todos aquellos sitios que le brindan al navegante la posibilidad de intercomunicarse dentro de la página, estos diseños web permiten crear aplicaciones dentro de la página, como encuestas, foros, comentarios estilo blog, pedidos on-line, etc.

El desarrollo de estos diseños web requieren mayor complejidad a la hora de crearlos, debido a que necesitan de conocimientos específicos en lo que concierne a lenguajes de programación, como así también la creación y gestión de una base de datos, ya que son sitios actualizables periódicamente y en los cuales se reflejan las elecciones o acciones del usuario en cualquier momento.

La gran ventaja con la que operan estos diseños web son la dinámica y servicio que brindan a través de la programación de aplicaciones específicas para cada empresa y target de clientes, proporcionando de esta manera sitios web agradables y útiles al momento de visitarlos.

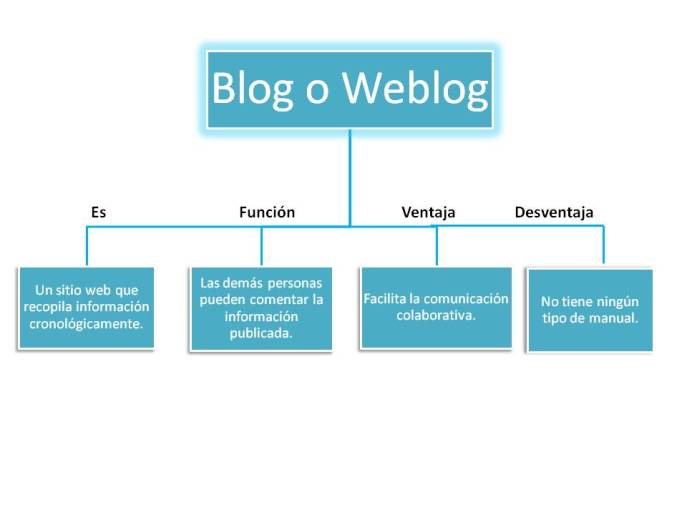

¿Weblogs o blogs?

¿Weblogs?

Mucho ruido… mucha comunidad… pero las definiciones de weblog varían de persona a persona. Y esto es así porque un weblog es fácil de crear y de usar, aunque un poco más complicado de explicar. A continuación varias definiciones de distintos autores que nos ayudaran a comprender de que estamos hablando:

Los weblogs o blogs son espacios personales de escritura en Internet. Su diseño dispone de un espacio para postear (escribir) un artículo (post o Log) y publicarlo en un browser, a cuya base queda registrado el día y la hora de publicación. El webloger (escritor) no necesita utilizar código html. De acuerdo a la opinión de algunos especialistas en comunicación, los Weblogs ocuparán un lugar importante entre los medios masivos del futuro. Estos nuevos sites de información se acercan cada vez más al principal objetivo del periodismo: la credibilidad, consigna que simultáneamente se aleja de los medios masivos.

Un blog, también conocido como weblog o cuaderno de bitácora (listado de sucesos), es un sitio Web periódicamente actualizado que recopila cronológicamente textos o artículos de uno o varios autores, apareciendo primero el más reciente, donde el autor conserva siempre la libertad de dejar publicado lo que crea pertinente. Habitualmente, en cada artículo, los lectores pueden escribir sus comentarios y el autor darles respuesta, de forma que es posible establecer un diálogo. El uso o temática de cada weblog es particular, los hay de tipo personal,periodístico, empresarial o corporativo, tecnológico, educativo (edublogs), políticos, etc.

Podemos decir que los weblogs son sitios en Internet basados en comentarios y opiniones sobre ciertos temas que son actualizadas con cierta regularidad -diariamente se supone- por la persona que ideó el blog o por varios usuarios cuando son grupales, pero que en cualquier caso los visitantes pueden introducir sus comentarios, de forma en que se genera una especie de conversación, elemento verdaderamente estructurador del fenómeno. También se puede decir que los blogs son sitios Web personales, en muchos casos, cuyo contenido lo envían los propios usuarios: noticias, opiniones, relatos, cuentos, vivencias personales, rumores, etc., mezcla de diario íntimo con foro de debate y noticiero personal, y normalmente ofrecen una visión de la realidad que normalmente no coincide con la de los grandes portales. Esta especie de boletines actualizados frecuentemente, en los que cualquiera puede expresar su pensamiento al momento sobre un tema, se componen normalmente de una secuencia de enlaces ordenados por riguroso orden cronológico que a su vez pueden ser comentados. En otros weblogs son los lectores los que deciden la disposición de los mensajes. Los usuarios pueden elaboran con sus visitas la lista de los textos más exitosos de la Web, apareciendo éstos en primer lugar cuando se accede a un sitio como un metablog que contenga dichos rankings o simplemente contribuyen con comentarios, réplicas y contrarréplicas a discusiones que se puedan generar en torno a una temática. Normalmente no hay censura, y cada usuario puede contar lo que quiera, aunque existe cierta pertinencia a los temas que los aglutinan. En los más visitados, sin embargo, un colectivo modera la entrada de los textos. Estos también según se entiende, pueden ser denominados como “colaborazines”.

Básicamente, un weblog (también llamado blog) es un espacio personal de escritura en Internet. Podes pensarlo como un diario online, un site que una persona usa para escribir periódicamente, en el que toda la escritura y el estilo se maneja vía Web. Un weblog está diseñado para que, como en un diario, cada artículo (post) tenga fecha de publicación, de forma tal que el escritor (weblogger) y los lectores pueden seguir un camino de todo lo publicado y archivado.

Un weblog no es más que una simpática propuesta de auto expresión comunitaria que no tienen mucho que ver con el periodismo.

Características técnicas

Existe una serie de elementos comunes a todos los blogs.

Comentarios: Mediante un formulario se permite, a otros usuarios de la web, añadir comentarios a cada entrada, pudiéndose generar un debate alrededor de sus contenidos..

Enlaces: Una particularidad que diferencia a los weblogs de los sitios de noticias es que las anotaciones suelen incluir múltiples enlaces a otras páginas web (no necesariamente weblogs) como referencias o para ampliar la información agregada. Y, además, la presencia de (entre otros):

- Un enlace permanente (permalinks) en cada anotación, para que cualquiera pueda citarla.

- Un archivo de las anotaciones anteriores.

- Una lista de enlaces a otros weblogs seleccionados o recomendados por los autores, denominada habitualmente blogroll).

Enlaces inversos: En algunos casos las anotaciones o historias permiten que se les haga trackback, un enlace inverso (o retroenlace) que permite, sobre todo, saber que alguien ha enlazado nuestra entrada, y avisar a otro weblog que estamos citando una de sus entradas o que se ha publicado un artículo relacionado. Todos los trackbacks aparecen automáticamente a continuación de la historia, junto con los comentarios. Pero no siempre es así.

Fotografías y vídeos: Es posible además agregar fotografías y vídeos a los blogs, a lo que recientemente se le ha llamado Fotologs o vlogs, respectivamente.

Sindicación: Otra característica de los weblogs es la multiplicidad de formatos en los que se publican. Aparte de HTML, suelen incluir algún medio para sindicarlos, es decir, para poder leerlos mediante un programa que pueda incluir datos procedentes de muchos medios diferentes. Generalmente se usa RSS para la sindicación, aunque desde el año 2004 ha comenzado a popularizarse también el Atom

Ventajas: Los blogs también presentan una diferenciación clara en cuanto a posibilidad de participación e interacción con respecto a la concepción clásica de los diarios digitales, donde los lectores no tenían la posibilidad de publicar y muy pocas posibilidades de hacer sentir su voz. Los modelos de interactividad, han sido más bien rudimentarios, escasos o nulos, y en todos los casos, muy controlados, como las cartas de lectores, en la que el medio decidía si la opinión del lector merecía ser publicada, y en qué condiciones. Frente a este modelo, los blogspresentan la posibilidad de sortear de alguna forma el filtro de los grandes medios y formar parte de esa constelación de “medios alternativos”.

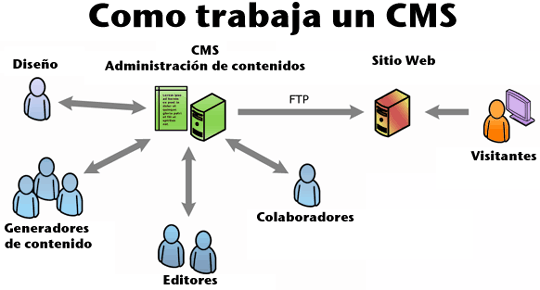

Gestores de Contenido

Permite la creación y administración de contenidos principalmente en páginas web.Consiste en una interfaz que controla una o varias bases de datos donde se aloja el contenido del sitio. El sistema permite manejar de manera independiente el contenido y el diseño. Así, es posible manejar el contenido y darle en cualquier momento un diseño distinto al sitio sin tener que darle formato al contenido de nuevo, además de permitir la fácil y controlada publicación en el sitio a varios editores. Un ejemplo clásico es el de editores que cargan el contenido al sistema y otro de nivel superior que permite que estos contenidos sean visibles a todo público.

Tipos de gestores de contenidos

Los Gestores de Contenido se pueden clasificar según diferentes criterios:

Por sus características

- Según el lenguaje de programación empleado, como por ejemplo Active Server Pages, Java, PHP, ASP.NET, Ruby On Rails, Python, PERL

- Según la licencia: Código abierto o Software propietario

Por su uso y funcionalidad

- Blogs; pensados para páginas personales.

- Foros; pensados para compartir opiniones.

- Wikis; pensados para el desarrollo colaborativo.

- Enseñanza; plataforma para contenidos de enseñanza on-line.

- Comercio electrónico; plataforma de gestión de usuarios, catálogo, compras y pagos.

- Publicaciones digitales.

- Difusión de contenido multimedia.

- Propósito general.

Ventajas y oportunidades

El gestor de contenidos facilita el acceso a la publicación de contenidos a un rango mayor de usuarios. Permite que sin conocimientos de programación ni maquetación cualquier usuario pueda añadir contenido en el portal web.

Además permite la gestión dinámica de usuarios y permisos, la colaboración de varios usuarios en el mismo trabajo, la interacción mediante herramientas de comunicación.

Los costes de gestión de la información son muchos menores ya que se elimina un eslabón de la cadena de publicación, el maquetador. La maquetación es hecha al inicio del proceso de implantación del gestor de contenidos.

La actualización, backup y reestructuración del portal son mucho más sencillas al tener todos los datos vitales del portal, los contenidos, en una base de datos estructurada en el servidor.

Fuentes:

http://www.simplificarweb.com.ar/paginas-web-estaticas.php

http://www.microsiervos.com/archivo/weblogs/weblogs.html

http://es.wikipedia.org/wiki/Sistema_de_gesti%C3%B3n_de_contenidos#Funcionamiento

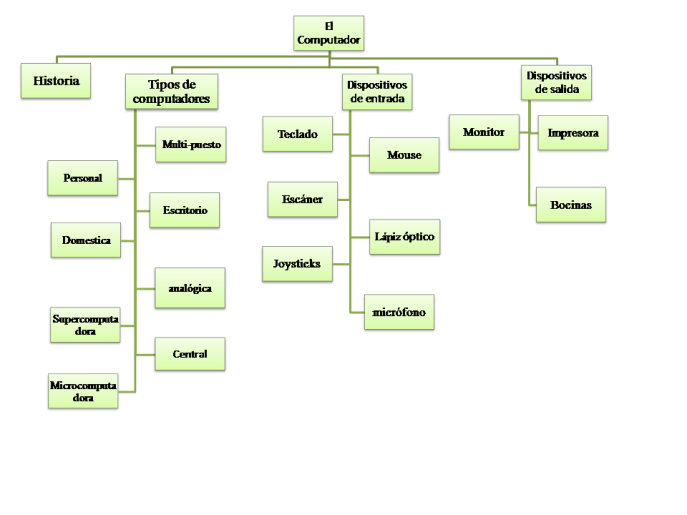

UNIDAD II: Arquitectura del Computador

EstándarLa arquitectura de computadoras es el diseño conceptual y la estructura operacional fundamental de un sistema de computadora. Es decir, es un modelo y una descripción funcional de los requerimientos y las implementaciones de diseño para varias partes de una computadora, con especial interés en la forma en que la unidad central de proceso (UCP) trabaja internamente y accede a las direcciones de memoria.

También suele definirse como la forma de seleccionar e interconectar componentes de hardware para crear computadoras según los requerimientos de funcionalidad, rendimiento y costo.

El ordenador recibe y envía la información a través de los periféricos por medio de los canales. La UCP es la encargada de procesar la información que le llega al ordenador. El intercambio de información se tiene que hacer con los periféricos y la UCP. Todas aquellas unidades de un sistema exceptuando la UCP se denomina periférico, por lo que el ordenador tiene dos partes bien diferenciadas, que son: la UCP (encargada de ejecutar programas y que está compuesta por la memoria principal, la Unidad aritmético lógica (UAL) y la Unidad de Control) y los periféricos (que pueden ser de entrada, salida, entrada-salida y comunicaciones).

La implantación de instrucciones es similar al uso de una serie de desmontaje en una fábrica de manufacturación. En las cadenas de montaje, el producto pasa a través de muchas etapas de producción antes de tener el producto desarmado. Cada etapa o segmento de la cadena está especializada en un área específica de la línea de producción y lleva a cabo siempre la misma actividad. Esta tecnología es aplicada en el diseño de procesadores eficientes.

A estos procesadores se les conoce como pipeline processors. Estos están compuestos por una lista de segmentos lineales y secuenciales en donde cada segmento lleva a cabo una tarea o un grupo de tareas computacionales. Los datos que provienen del exterior se introducen en el sistema para ser procesados. La computadora realiza operaciones con los datos que tiene almacenados en memoria, produce nuevos datos o información para uso externo.

Las arquitecturas y los conjuntos de instrucciones se pueden clasificar considerando los siguientes aspectos:

- Almacenamiento de operativos en la UPC: dónde se ubican los operadores aparte de la substractora informativa (SI)

- Número de operandos explícitos por instrucción: cuántos operandos se expresan en forma explícita en una instrucción típica. Normalmente son 0, 1, 2 y 3.

- Posición del operando: ¿Puede cualquier operando estar en memoria?, o deben estar algunos o todos en los registros internos de la UPC. Cómo se especifica la dirección de memoria (modos de direccionamiento disponibles).

- Operaciones: Qué operaciones están disponibles en el conjunto de instrucciones.

- Tipo y tamaño de operandos y cómo se especifican.

Ventajas de las arquitecturas

- Pila: Modelo sencillo para evaluación de expresiones (notación polaca inversa). Instrucciones cortas pueden dar una buena densidad de código.

- Acumulador: Instrucciones cortas. Minimiza estados internos de la máquina (unidad de control sencilla).

- Registro: Modelo más general para el código de instrucciones parecidas. Automatiza generación de código y la reutilización de operandos. Reduce el tráfico a memoria. Una computadora actualmente tiene como estándar 32 registros. El acceso a los datos es más rápido, y veloz.

Desventajas de las arquitecturas

- Pila: A una pila no se puede acceder aleatoriamente. Esta limitación hace difícil generar código eficiente. También dificulta una implementación eficiente, ya que la pila llega a ser un cuello de botella es decir que existe dificultad para la transferencia de datos en su velocidad mk.

- Acumulador: Como el acumulador es solamente almacenamiento temporal, el tráfico de memoria es el más alto en esta aproximación.

- Registro: Todos los operadores deben ser nombrados, conduciendo a instrucciones más largas.

Placa Madre

La tarjeta o placa madre, en inglés motherboard, permite integrar a todos los componentes de la computadora y se trata de un circuito impreso compuesto por varios conectores. Existen distintos tipos de motherboard, entre ellas:

Placa AT: esta placa es la utilizada por IBM AT INC y fue creada en el año 1984. Su tamaño es de aproximadamente 305 mm de ancho por 300 a 330 mm de profundidad. Esta tarjeta resulta ser de gran tamaño para las unidades de disco más avanzadas, por lo que no puede introducirse en ellas. Otra desventaja que presenta es que suele inducir errores por medio de su conector con la fuente de alimentación. En la actualidad, este tipo de placas madre no se utiliza para la producción de ninguna computadora.

Placa Baby AT: esta placa fue creada en el año 1985 y si bien es de menor tamaño que la AT, su funcionalidad es muy similar. Mide 216 mm de ancho por 244 a 330 mm de profundidad esto lo que permite es una mayor facilidad para introducirlas en las cajas más pequeñas, por lo que tuvieron mucho éxito en el mercado. De todas maneras, este modelo presenta fallas muy similares al anterior. Entre ellas, el tener un gran número de cables que no permiten una correcta ventilación así como también presentar el micro distanciado de la entrada de alimentación.

Placa ATX: esta es creada en el año 1995 por Intel. Su tamaño es de 305 mm de ancho por 204 mm de profundidad. Este modelo logró superar las desventajas presentes en los otros dos. En esta placa, los puertos más utilizados se ubican de forma opuesta al de los slots de aplicación. El puerto DIN 5 del teclado se vio reemplazado por las tomas TS/2 de mouse y teclado, y se lo ubicó en mismo lado que los otros puertos. Lo que esto permitió fue que numerosas tarjetas puedan ser introducidas en la placa madre, disminuyendo costos y optimizando la ventilación.

Placa micro AXT: este formato presenta un tamaño reducido, que no supera los 244 mm de ancho por los 244 mm de profundidad. Al ser tan pequeña, solo presenta espacio para 1 o 2 slots AGP y/o PCI. Es por esto que suelen agregarse puertos USB o FireWire. Esta es la placa más moderna que existe actualmente.

Formato ATX («Advanced Tecnology eXtended»): es el estándar más utilizado actualmente, mide 24.58 cm. de largo X 30.72 cm. de ancho. Integra ciertos puertos ya integrados en la placa por lo que evita el uso de cables extras y utilizan fuente de alimentación ATX.

Formato «Baby AT («Baby Advanced Tecnology»): es una placa que busca solucionar el problema del tamaño del AT, es de menores dimensiones, 33.28 cm. de largo por 21.76 de ancho. Integra solamente el conector para el teclado (PS/1) y utilizan conector para fuente AT.

Formato AT («Advanced Tecnology»): es de las más antiguas, es una placa que mide 33.28 cm. de largo X 30.72 de ancho, por lo que es muy grande y dificulta la inserción y manipulación de elementos internos y utilizan fuente AT de alimentación. Puede ó no integrar puertos en la placa.

El procesador

También conocido como CPU o micro, es el cerebro del PC. Se encarga de hacer funcionar a las aplicaciones y el sistema operativo dando respuesta a las órdenes que le envías a través de los periféricos de entrada como el teclado o el ratón.

Físicamente, el micro, no es más que una pastilla de silicio. En un PC se coloca sobre la placa base en un conector que se denomina socket. En un laptop es normal que te lo encuentres soldado. La placa permite la conexión con los restantes dispositivos de tu equipo como son la memoria RAM, la tarjeta gráfica o el disco duro usando para ello un conjunto de circuitos y chips denominado chipset.

Es uno de los elementos del PC que más ha evolucionado a lo largo del tiempo. Cada nueva generación ha permitido reducir el tamaño de los transistores que se encuentran en su interior permitiendo integrar un mayor número de bloques funcionales. Puedes ver los transistores como pequeños ladrillos que unidos dan forma al micro.

Estas mejoras han permitido aumentar la integración permitiendo incluir más bloques funcionales en su interior. En un principio fue el controlador de memoria, después la tarjeta gráfica y en un futuro muy cercano, pasaremos del concepto de procesador a lo que se denomina SOC, es decir, un chip con todos los elementos de la placa base integrados.

¿Qué partes internas tiene un procesador?

Ten en cuenta que no todos son iguales pero la mayoría de ellos incluyen entre otros elementos:

Núcleos. Un núcleo no es más que un procesador en miniatura. Tener varios integrados permite trabajar con más de una aplicación al mismo tiempo y además puedes acelerar ciertos tipos de procesamiento.

Cache. Uno de los sistemas más importantes dentro de un PC es su sistema de memoria el cual esta compuesto por varios elementos. La memoria cache, interna al procesador, se usa para mejorar la velocidad de los accesos a la memoria RAM. Si un dato esta en la cache ya no tendremos que ir a buscarlo y por lo tanto el procesado es mucho más rápido.

Esta organizada en varios niveles. Será tarea del micro dejar los datos que más se usen lo más cerca del micro.

Controlador de memoria. Al incorporar el controlador de memoria en el interior del procesador y quitarlo de la placa base se consigue que el acceso a la memoria RAM sea más eficiente. Esto tiene un inconveniente y es que sólo puedes usar el tipo de memoria para la que tu procesador este preparado.

Tarjeta gráfica. Si integran este componente ya no hablamos de CPUs sino de APUs. Ya no estaríamos ante un micro convencional si no ante un hibrido entre procesador y tarjeta gráfica.

Otros elementos. Los micros han incorporado otros elementos que se encontraban antes sobre la placa base. Por ejemplo, el controlador de PCI Express, aumentando la velocidad con la que el micro es capaz de comunicarse con una tarjeta gráfica discreta.

¿Cómo funciona de forma interna un procesador?

El funcionamiento de un procesador se puede dividir en las siguientes etapas:

Se lee una instrucción de memoria. Para que te puedas hacer una idea de la complejidad de un procesador actual su conjunto de instrucciones esta compuesto por más de mil diferentes y va creciendo con el tiempo. Se busca siempre mejorar las prestaciones.

Se buscan los datos necesarios. No todas las instrucciones son iguales y algunas necesitaran de datos, los cuales normalmente estarán en la memoria RAM, para poder llevar a cabo su trabajo. Si este es el caso hay que esperar a tenerlos disponibles. Es muy importante que el flujo de datos y de instrucciones sea lo más rápido posible para que no se produzcan bloqueos.

Se realiza la operación. Una vez que se tiene todo se ejecuta la operación, para esto puede ser necesario el trabajo de varios bloques dentro del propio procesador como puede ser launidad aritmética lógica o la de punto flotante.

Se pasa a la siguiente instrucción. Que no es siempre es la que se encuentra a continuación en la memoria. Muchas instrucciones pueden cambiar el flujo del programa y permitir saltos o repetir ciertas acciones hasta que se cumpla una condición.

Los buses

La comunicación del microprocesador con los periféricos tiene lugar a través de cables especiales denominados buses. Los buses son los caminos por los que fluye la información; podrían compararse con las autopistas por las que circulan los coches. Utilizando este símil, se pueden considerar dos factores importantes que determinan la calidad: el número de carriles y la velocidad a la que circular por ella. Del mismo modo la calidad de los buses depende delnúmero de bits que pueden fluir al mismo tiempo y de la velocidad con la que éstos lo hacen.

Clases de buses:

Bus de datos

Mueve los datos entre los dispositivos del hardware de Entrada como el teclado, el ratón, etc.; de salida como la Impresora, el Monitor; y de Almacenamiento como el Disco Duro, el Disquete o la Memoria-Flash. Estas transferencias que se dan a través del Bus de Datos son gobernadas por varios dispositivos y métodos, de los cuales el Controlador PCI, «Peripheral Component Interconnect», Interconexión de componentes Periféricos, es uno de los principales. Su trabajo equivale, simplificando mucho el asunto, a una central de semáforos para el tráfico en las calles de una ciudad.

Bus de direcciones

El Bus de Direcciones, por otra parte, está vinculado al bloque de Control de la CPU para tomar y colocar datos en el Sub-sistema de Memoria durante la ejecución de los procesos de cómputo.

Para el Bus de Direcciones, el «ancho de canal» explica así mismo la cantidad de ubicaciones o Direcciones diferentes que el microprocesador puede alcanzar. Esa cantidad de ubicaciones resulta de elevar el 2 a la 32ª potencia. «2» porque son dos las señales binarias, los bits 1 y 0; y «32ª potencia» porque las 32 pistas del Bus de Direcciones son, en un instante dado, un conjunto de 32 bits. Nos sirve para calcular la capacidad de memoria en el CPU.

Bus de control

Este bus transporta señales de estado de las operaciones efectuadas por la CPU. El método utilizado por el ordenador para sincronizar las distintas operaciones es por medio de un reloj interno que posee el ordenador y facilita la sincronización y evita las colisiones de operaciones (unidad de control). Estas operaciones se transmiten en un modo bidireccional y unidireccional.

Memoria de acceso aleatoria (RAM)

La memoria de acceso aleatorio (en inglés: random-access memory) se utiliza como memoria de trabajo para el sistema operativo, los programas y la mayoría del software. Es allí donde se cargan todas las instrucciones que ejecutan el procesador y otras unidades de cómputo. Se denominan «de acceso aleatorio» porque se puede leer o escribir en una posición de memoria con un tiempo de espera igual para cualquier posición, no siendo necesario seguir un orden para acceder a la información de la manera más rápida posible. Durante el encendido del computador, la rutina POST verifica que los módulos de memoria RAM estén conectados de manera correcta. En el caso que no existan o no se detecten los módulos, la mayoría de tarjetas madres emiten una serie de pitidos que indican la ausencia de memoria principal. Terminado ese proceso, la memoria BIOS puede realizar un test básico sobre la memoria RAM indicando fallos mayores en la misma.

La expresión memoria RAM se utiliza frecuentemente para describir a los módulos de memoria utilizados en los computadores personales y servidores. En el sentido estricto, esta memoria es solo una variedad de la memoria de acceso aleatorio: las ROM,memorias Flash, caché (SRAM), los registros en procesadores y otras unidades de procesamiento también poseen la cualidad de presentar retardos de acceso iguales para cualquier posición. Los módulos de RAM son la presentación comercial de este tipo de memoria, que se compone de circuitos integrados soldados sobre un circuito impreso independiente, en otros dispositivos como las consolas de videojuegos, la RAM va soldada directamente sobre la placa principal.

Uno de los primeros tipos de memoria RAM fue la memoria de núcleo magnético, desarrollada entre 1949 y 1952 y usada en muchos computadores hasta el desarrollo de circuitos integrados a finales de los años 60 y principios de los 70. Esa memoria requería que cada bit estuviera almacenado en un toroide de material ferromágnetico de algunos milímetros de diámetro, lo que resultaba en dispositivos con una capacidad de memoria muy pequeña. Antes que eso, las computadoras usaban relés y líneas de retardo de varios tipos construidas para implementar las funciones de memoria principal con o sin acceso aleatorio.

En 1969 fueron lanzadas una de las primeras memorias RAM basadas en semiconductores de silicio por parte de Intel con el integrado 3101 de 64 bits de memoria y para el siguiente año se presentó una memoria DRAM de 1024bytes, referencia 1103 que se constituyó en un hito, ya que fue la primera en ser comercializada con éxito, lo que significó el principio del fin para las memorias de núcleo magnético. En comparación con los integrados de memoria DRAM actuales, la 1103 es primitiva en varios aspectos, pero tenía un desempeño mayor que la memoria de núcleos.

En 1973 se presentó una innovación que permitió otra miniaturización y se convirtió en estándar para las memorias DRAM: la multiplexación en tiempo de la direcciones de memoria. MOSTEK lanzó la referencia MK4096 de 4096 bytes en un empaque de 16 pines,1 mientras sus competidores las fabricaban en el empaque DIP de 22 pines. El esquema de direccionamiento2 se convirtió en un estándar de facto debido a la gran popularidad que logró esta referencia de DRAM. Para finales de los 70 los integrados eran usados en la mayoría de computadores nuevos, se soldaban directamente a las placas base o se instalaban en zócalos, de manera que ocupaban un área extensa de circuito impreso. Con el tiempo se hizo obvio que la instalación de RAM sobre el impreso principal, impedía la miniaturización , entonces se idearon los primeros módulos de memoria como el SIPP, aprovechando las ventajas de la construcción modular. El formato SIMM fue una mejora al anterior, eliminando los pines metálicos y dejando unas áreas de cobre en uno de los bordes del impreso, muy similares a los de las tarjetas de expansión, de hecho los módulos SIPP y los primeros SIMM tienen la misma distribución de pines.

A finales de los 80 el aumento en la velocidad de los procesadores y el aumento en el ancho de banda requerido, dejaron rezagadas a las memorias DRAM con el esquema original MOSTEK, de manera que se realizaron una serie de mejoras en el direccionamiento como las siguientes:

- FPM-RAM (Fast Page Mode RAM)

Inspirado en técnicas como el «Burst Mode» usado en procesadores como el Intel 486,3 se implantó un modo direccionamiento en el que el controlador de memoria envía una sola dirección y recibe a cambio esa y varias consecutivas sin necesidad de generar todas las direcciones. Esto supone un ahorro de tiempos ya que ciertas operaciones son repetitivas cuando se desea acceder a muchas posiciones consecutivas. Funciona como si deseáramos visitar todas las casas en una calle: después de la primera vez no seria necesario decir el número de la calle únicamente seguir la misma. Se fabricaban con tiempos de acceso de 70 ó 60 ns y fueron muy populares en sistemas basados en el 486 y los primeros Pentium.

- EDO-RAM (Extended Data Output RAM)

Lanzada en 1995 y con tiempos de accesos de 40 o 30 ns suponía una mejora sobre su antecesora la FPM. La EDO, también es capaz de enviar direcciones contiguas pero direcciona la columna que va utilizar mientras que se lee la información de la columna anterior, dando como resultado una eliminación de estados de espera, manteniendo activo el búffer de salida hasta que comienza el próximo ciclo de lectura.

- BEDO-RAM (Burst Extended Data Output RAM)

Fue la evolución de la EDO RAM y competidora de la SDRAM, fue presentada en 1997. Era un tipo de memoria que usaba generadores internos de direcciones y accedía a más de una posición de memoria en cada ciclo de reloj, de manera que lograba un desempeño un 50% mejor que la EDO. Nunca salió al mercado, dado que Intel y otros fabricantes se decidieron por esquemas de memoria sincrónicos que si bien tenían mucho del direccionamiento MOSTEK, agregan funcionalidades distintas como señales de reloj.

Tecnología de memorias

La tecnología de memoria actual usa una señal de sincronización para realizar las funciones de lectura-escritura de manera que siempre está sincronizada con un reloj del bus de memoria, a diferencia de las antiguas memorias FPM y EDO que eran asíncronas. Hace más de una década toda la industria se decantó por las tecnologías síncronas, ya que permiten construir integrados que funcionen a una frecuencia superior a 66 MHz.

Tipos de DIMMs según su cantidad de Contactos o Pines:

- 72-pin SO-DIMM (no el mismo que un 72-pin SIMM), usados por FPM DRAM y EDO DRAM

- 100-pin DIMM, usados por printer SDRAM

- 144-pin SO-DIMM, usados por SDR SDRAM

- 168-pin DIMM, usados por SDR SDRAM (menos frecuente para FPM/EDO DRAM en áreas de trabajo y/o servidores)

- 172-pin MicroDIMM, usados por DDR SDRAM

- 184-pin DIMM, usados por DDR SDRAM

- 200-pin SO-DIMM, usados por DDR SDRAM y DDR2 SDRAM

- 204-pin SO-DIMM, usados por DDR3 SDRAM

- 240-pin DIMM, usados por DDR2 SDRAM, DDR3 SDRAM y FB-DIMM DRAM

- 244-pin MiniDIMM, usados por DDR2 SDRAM

SDR SDRAM

Memoria síncrona, con tiempos de acceso de entre 25 y 10 ns y que se presentan en módulos DIMM de 168 contactos. Fue utilizada en los Pentium IIy en los Pentium III , así como en los AMD K6, AMD Athlon K7 y Duron. Está muy extendida la creencia de que se llama SDRAM a secas, y que la denominación SDR SDRAM es para diferenciarla de la memoria DDR, pero no es así, simplemente se extendió muy rápido la denominación incorrecta. El nombre correcto es SDR SDRAM ya que ambas (tanto la SDR como la DDR) son memorias síncronas dinámicas. Los tipos disponibles son:

- PC66: SDR SDRAM, funciona a un máx de 66,6 MHz.

- PC100: SDR SDRAM, funciona a un máx de 100 MHz.

- PC133: SDR SDRAM, funciona a un máx de 133,3 MHz.

RDRAM

Se presentan en módulos RIMM de 184 contactos. Fue utilizada en los Pentium IV . Era la memoria más rápida en su tiempo, pero por su elevado costo fue rápidamente cambiada por la económica DDR. Los tipos disponibles son:

- PC600: RIMM RDRAM, funciona a un máximo de 300 MHz.

- PC700: RIMM RDRAM, funciona a un máximo de 356 MHz.

- PC800: RIMM RDRAM, funciona a un máximo de 400 MHz.

- PC1066: RIMM RDRAM, funciona a un máximo de 533 MHz.

DDR SDRAM

Memoria síncrona, envía los datos dos veces por cada ciclo de reloj. De este modo trabaja al doble de velocidad del bus del sistema, sin necesidad de aumentar la frecuencia de reloj. Se presenta en módulos DIMM de 184 contactos en el caso de ordenador de escritorio y en módulos de 144 contactos para los ordenadores portátiles. Los tipos disponibles son:

- PC1600 o DDR 200: funciona a un máx de 200 MHz.

- PC2100 o DDR 266: funciona a un máx de 266,6 MHz.

- PC2700 o DDR 333: funciona a un máx de 333,3 MHz.

- PC3200 o DDR 400: funciona a un máx de 400 MHz.

- PC4500 o DRR 500: funciona a una máx de 500 MHz

DDR2 SDRAM

Las memorias DDR 2 son una mejora de las memorias DDR (Double Data Rate), que permiten que los búferes de entrada/salida trabajen al doble de la frecuencia del núcleo, permitiendo que durante cada ciclo de reloj se realicen cuatro transferencias. Se presentan en módulos DIMM de 240 contactos. Los tipos disponibles son:

- PC2-4200 o DDR2-533: funciona a un máx de 533,3 MHz.

- PC2-5300 o DDR2-667: funciona a un máx de 666,6 MHz.

- PC2-6400 o DDR2-800: funciona a un máx de 800 MHz.

- PC2-8600 o DDR2-1066: funciona a un máx de 1066,6 MHz.

- PC2-9000 o DDR2-1200: funciona a un máx de 1200 MHz

DDR3 SDRAM

Las memorias DDR 3 son una mejora de las memorias DDR 2, proporcionan significantes mejoras en el rendimiento en niveles de bajo voltaje, lo que lleva consigo una disminución del gasto global de consumo. Los módulos DIMM DDR 3 tienen 240 pines, el mismo número que DDR 2; sin embargo, los DIMMs son físicamente incompatibles, debido a una ubicación diferente de la muesca. Los tipos disponibles son:

- PC3-6400 o DDR3-800: funciona a un máx de 800 MHz.

- PC3-8500 o DDR3-1066: funciona a un máx de 1066,6 MHz.

- PC3-10600 o DDR3-1333: funciona a un máx de 1333,3 MHz.

- PC3-12800 o DDR3-1600: funciona a un máx de 1600 MHz.

- PC3-14900 o DDR3-1866: funciona a un máx de 1866,6 MHz.

- PC3-17000 o DDR3-2133: funciona a un máx de 2133,3 MHz.

- PC3-19200 o DDR3-2400: funciona a un máx de 2400 MHz.

- PC3-21300 o DDR3-2666: funciona a un máx de 2666,6 MHz

cache

el caché de CPU, es un búfer especial de memoria que poseen losordenadores. Funciona de una manera similar a como lo hace la memoria principal (RAM), pero es de menor tamaño y de acceso más rápido. Es usado por la unidad central de procesamiento para reducir el tiempo de acceso a datos ubicados en la memoria principal que se utilizan con más frecuencia.

Cuando se accede por primera vez a un dato, se hace una copia en el caché; los accesos siguientes se realizan a dicha copia, haciendo que el tiempo de acceso medio al dato sea menor. Cuando el procesador necesita leer o escribir en una ubicación en memoria principal, primero verifica si una copia de los datos está en el caché. Si es así, el procesador de inmediato lee o escribe en la memoria caché, que es mucho más rápido que de la lectura o la escritura a la memoria principal.

La unidad caché es un sistema especial de almacenamiento de alta velocidad. Puede ser tanto un área reservada de la memoria principal como un dispositivo de almacenamiento de alta velocidad independiente. Hay dos tipos de caché frecuentemente usados en las computadoras personales: memoria caché y caché de disco. Una memoria caché, llamada también a veces almacenamiento caché o RAM caché, es una parte de memoria RAM estática de alta velocidad (SRAM) más rápida que la RAM dinámica (DRAM) usada como memoria principal. La memoria caché es efectiva dado que los programas acceden una y otra vez a los mismos datos o instrucciones. Guardando esta información en SRAM, la computadora evita acceder a la lenta DRAM.

Cuando se encuentra un dato en el caché, se dice que se ha producido un acierto, siendo un caché juzgado por su tasa de aciertos (hit rate). Los sistemas de memoria caché usan una tecnología conocida por caché inteligente en la cual el sistema puede reconocer cierto tipo de datos usados frecuentemente. Las estrategias para determinar qué información debe de ser puesta en el caché constituyen uno de los problemas más interesantes en la ciencia de las computadoras. Algunas memorias caché están construidas en la arquitectura de los microprocesadores. Por ejemplo, el procesador Pentium II tiene un caché L2 de 512 KiB.

El caché de disco trabaja sobre los mismos principios que la memoria caché, pero en lugar de usar SRAM de alta velocidad, usa la convencional memoria principal. Los datos más recientes del disco duro a los que se ha accedido (así como los sectores adyacentes) se almacenan en un buffer de memoria. Cuando el programa necesita acceder a datos del disco, lo primero que comprueba es el caché del disco para ver si los datos ya están ahí. El caché de disco puede mejorar drásticamente el rendimiento de las aplicaciones, dado que acceder a un byte de datos en RAM puede ser miles de veces más rápido que acceder a un byte del disco duro.

Ranuras de expansión

Una ranura de expansión (también llamada slot de expansión) es un elemento de la placa base de un computador, que permite conectar a esta una tarjeta adicional o de expansión, la cual suele realizar funciones de control de dispositivos periféricos adicionales, tales como monitores, impresoras o unidades de disco. En las tarjetas madre del tipo LPX las ranuras de expansión no se encuentran sobre la placa sino en un conector especial denominado riser card.

Las ranuras están conectadas entre sí. Una computadora personal dispone generalmente de ocho unidades, aunque puede llegar hasta doce.

| ranura de expansión XT |

Una ranura de expansión, bus de expansión ó «slot» es un elemento que permite introducir dentro de si, otros dispositivos llamados tarjetas de expansión (son tarjetas que se introducen en la ranura de expansión y dan mas prestaciones al equipo de cómputo).

XT proviene de las siglas de («eXtended Tecnology«) ó tecnología avanzada. Este tipo de ranura se comercializa en 1980 con una capacidad de datos de 8 bits.

Los bits en las ranuras de expansión significan la capacidad de datos que es capaz de proveer, este dato es importante ya que por medio de una fórmula, es posible determinar la transferencia máxima de la ranura ó de una tarjeta de expansión. Esto se describe en la sección: Bus y bus de datos XT de esta misma página.

Fue desplazada del mercado por la ranura de expansión AT – ISA.

| ranura de expansión ISA |

Una ranura de expansión, bus de expansión ó «Slot» es un elemento que permite introducir dentro de si, otros dispositivos llamados tarjetas de expansión (son tarjetas que se introducen en la ranura de expansión y dan mas prestaciones al equipo de cómputo).

ISA proviene de las siglas de («Industry Standard Architecture«) ó arquitectura estándar de la industria, también llamada en un inicio como bus AT («Advanced Tecnology«), esto es, tecnología avanzada. Este tipo de ranura se comercializa en 1980 y hay 2 versiones, una de 8 bits y 16 bits.

Los bits en las ranuras de expansión significan la capacidad de datos que es capaz de proveer, este dato es importante ya que por medio de una fórmula, es posible determinar la transferencia máxima de la ranura ó de una tarjeta de expansión. Esto se describe en la sección: Bus y bus de datos ISA de esta misma página.

Compitió directamente en el mercado contra la ranura de expansión EISA y la ranura de expansión VESA.

Fue desplazada del mercado por la ranura de expansión PCI.

| ranura de expansión MCA |

Una ranura de expansión, bus de expansión ó «slot» es un elemento que permite introducir dentro de si, otros dispositivos llamados tarjetas de expansión (son tarjetas que se introducen en la ranura de expansión y dan mas prestaciones al equipo de cómputo).

MCA proviene de las siglas de («Micro Channel Architecture«) ó arquitectura micro canal de IBM®. Este tipo de ranura se comercializaba con una capacidad de datos de 16 bits y 32 bits.

Los bits en las ranuras de expansión significan la capacidad de datos que es capaz de proveer, este dato es importante ya que por medio de una fórmula, es posible determinar la transferencia máxima de la ranura ó de una tarjeta de expansión. Esto se describe en la sección: Bus y bus de datos MCA de esta misma página.

Compitió directamente en el mercado contra la ranura de expansión EISA, pero no tuvo mucho éxito y fue superada por ese estándar.

| ranura de expansión VESA |

Una ranura de expansión, bus de expansión ó «slot» es un elemento que permite introducir dentro de si, otros dispositivos llamados tarjetas de expansión (son tarjetas que se introducen en la ranura de expansión y dan mas prestaciones al equipo de cómputo).

VESA proviene de las siglas de («Video Electronics Standards Association«) ó Asociación de estándares de electrónicos y video, ó también llamado («VESA Local Bus«), bus local VESA. Este tipo de ranura toma su nombre de local por el hecho de que está conectado directamente con el microprocesador e inclusive funcionando casi a su misma velocidad. Este tipo de ranura se comercializaba con una capacidad de datos de 32 bits y 64 bits para el microprocesador Intel® Pentium.

Los bits en las ranuras de expansión significan la capacidad de datos que es capaz de proveer, este dato es importante ya que por medio de una fórmula, es posible determinar la transferencia máxima de la ranura ó de una tarjeta de expansión. Esto se describe en la sección: Bus y bus de datos VESA de esta misma página.

Compitió en el mercado directamente contra las ranuras ISA y MCA a pesar de que tiene soporte para ese tipo de tarjetas.

La ranura VESA tuvo mucho éxito por su gran compatibilidad, pero fue desplazada por la ranura de expansión PCI.

| ranura de expansión – Bus EISA |

Una ranura de expansión, bus de expansión ó «Slot» es un elemento que permite introducir dentro de si, otros dispositivos llamados tarjetas de expansión (son tarjetas que se introducen en la ranura de expansión y dan mas prestaciones al equipo de cómputo).

EISA proviene de las siglas de («Extended Industry Standard Architecture«) ó arquitectura estándar de la industria. Este tipo de ranura se comercializa con una capacidad de datos de 32 bits.

Los bits en las ranuras de expansión significan la capacidad de datos que es capaz de proveer, este dato es importante ya que por medio de una fórmula, es posible determinar la transferencia máxima de la ranura ó de una tarjeta de expansión. e diseñó para competir en el mercado contra la ranura de expansión MCA de IBM®.

Fue desplazada del mercado por la ranura de expansión PCI.

| ranura de expansión PCMCIA |

Una ranura de expansión, bus de expansión ó «slot» es un elemento que permite introducir dentro de si, otros dispositivos llamados tarjetas de expansión (son tarjetas que se introducen en la ranura de expansión y dan mas prestaciones al equipo de cómputo).

PCMCIA proviene de las siglas de («Personal Computer Memory Card International Association«) ó asociacióninternacional de tarjetas de memoria para computadoras personales. Toma el nombre debido a que comenzaba la popularidad de los dispositivos portátiles (Notebooks principalmente) y se requería de dispositivos pequeños para su uso en estos equipos.

Compite directamente en el mercado contra dispositivos USB, ya que están reemplazando a las tarjetas internas

| ranura de expansión PCI |

Una ranura de expansión, bus de expansión ó «Slot» es un elemento que permite introducir dentro de si, otros dispositivos llamados tarjetas de expansión (son tarjetas que se introducen en la ranura de expansión y dan mas prestaciones al equipo de cómputo).

PCI proviene de las siglas de («Peripheral Components Interconect«) ó componentes periféricos interconectados. Este tipo de ranura fue desarrollado por Intel® y lanzado al mercado en 1993, se comercializa con una capacidad de datos de 32 bits y 64 bits para el microprocesador Intel® Pentium.

Los bits en las ranuras de expansión significan la capacidad de datos que es capaz de proveer, este dato es importante ya que por medio de una fórmula, es posible determinar la transferencia máxima de la ranura ó de una tarjeta de expansión. Esto se describe en la sección: Bus y bus de datos PCI de esta misma página.

Reemplazó del mercado a la ranura de expansión VESA.

Compite actualmente en el mercado contra las ranuras AGP/AGP 8X y PCI-Express.

| ranura ó puerto AGP |

Una ranura de expansión, bus de expansión ó «slot» es un elemento que permite introducir dentro de si, otros dispositivos llamados tarjetas de expansión (son tarjetas que se introducen en la ranura de expansión y dan mas prestaciones al equipo de cómputo), mientras que la definición de Intel® de su conector es como puerto debido a sus características, por ello aún no esta bien determinado el tipo que es.

AGP proviene de las siglas de («Accelerated Graphics Port«) ó puerto acelerador de gráficos. Este tipo de ranura-puerto fue desarrollado por Intel® y lanzado al mercado en 1997 exclusivamente para soporte de gráficos.

Los bits en las ranuras de expansión significan la capacidad de datos que es capaz de proveer, este dato es importante ya que por medio de una fórmula, es posible determinar la transferencia máxima de la ranura ó de una tarjeta de expansión. Esto se describe en la sección: Bus y bus de datos AGP de esta misma página.

Compite actualmente en el mercado contra las ranuras PCI y las ranuras PCI-Express.

| ranura de expansión AMR/CNR |

Una ranura de expansión, bus de expansión ó «slot» es un elemento que permite introducir dentro de si, otros dispositivos llamados tarjetas de expansión (son tarjetas que se introducen en la ranura de expansión y dan mas prestaciones al equipo de cómputo).

AMR proviene de las siglas de («Audio Modem Riser«) ó manejador de audio y módem. Este tipo de ranura fue desarrollado por Intel® y lanzado al mercado en 1988, mientras que CNR proviene de («CommunicationNetwork Riser«) ó manejador de redes de comunicaciones lanzado en 1990.

Compiten actualmente en el mercado contra la ranura de expansión PCI.

| ranura de expansión PCI-E |

Una ranura de expansión, bus de expansión ó «Slot» es un elemento que permite introducir dentro de si, otros dispositivos llamados tarjetas de expansión (son tarjetas que se introducen en la ranura de expansión y dan mas prestaciones al equipo de cómputo).

PCI-E proviene de las siglas de («Peripheral Components Interconect-Express«) ó componentes periféricos interconectados en modo inmediato. Este tipo de ranura fue desarrollado por Intel® y lanzado al mercado en 2004, con una forma de transmisión de tipo serial (mientras el PCI lo hace de forma paralela).

Los bits en las ranuras de expansión significan la capacidad de datos que es capaz de proveer, este dato es importante ya que por medio de una fórmula, es posible determinar la transferencia máxima de la ranura ó de una tarjeta de expansión. Esto se describe en la sección: Bus y bus de datos PCI-E de esta misma página.

Compite actualmente en el mercado contra las ranuras AGP 8X y aún contra las ranuras PCI.

Puerto Serie

Un puerto serie o puerto serial es una interfaz de comunicaciones de datos digitales, frecuentemente utilizado por computadoras y periféricos, donde la información es transmitida bit a bit enviando un solo bit a la vez, en contraste con elpuerto paralelo que envía varios bits simultáneamente. La comparación entre la transmisión en serie y en paralelo se puede explicar usando una analogía con lascarreteras. Una carretera tradicional de un sólo carril por sentido sería como la transmisión en serie y una autovía con varios carriles por sentido sería la transmisión en paralelo, siendo los vehículos los bits que circulan por el cable.

Puerto Paralel

Un puerto paralelo es una interfaz entre una computadora y un periférico, cuya principal característica es que los bits de datos viajan juntos, enviando un paquete debyte a la vez. Es decir, se implementa un cable o una vía física para cada bit de datos formando un bus. Mediante el puerto paralelo podemos controlar también periféricos como focos, motores entre otros dispositivos, adecuados para automatización.

El cable paralelo es el conector físico entre el puerto paralelo y el dispositivo periférico. En un puerto paralelo habrá una serie de bits de control en vías aparte que irán en ambos sentidos por caminos distintos.

En contraposición al puerto paralelo está el puerto serie, que envía los datos bit a bit por el mismo hilo.

Universal Serial Bus (USB)

El Universal Serial Bus (USB) (bus universal en serie BUS) es un estándar industrial desarrollado a mediados de los años 1990 que define los cables, conectores y protocolos usados en un bus para conectar, comunicar y proveer de alimentación eléctrica entre ordenadores y periféricos y dispositivos electrónicos. La iniciativa del desarrollo partió de Intel que creó el USB Implementers Forum junto con IBM, Northern Telecom, Compaq,Microsoft, Digital Equipment Corporation y NEC en 1996 se lanzó la primera especificación (USB 1.0), la cual no fue popular, hasta 1998 con (USB 1.1). Actualmente agrupa a más de 685 compañías.

USB fue diseñado para estandarizar la conexión de periféricos, comomouse, teclados, memorias USB, joysticks, escáneres, cámaras digitales,teléfonos móviles, reproductores multimedia, impresoras, dispositivos multifuncionales, sistemas de adquisición de datos, módems, tarjetas de red, tarjetas de sonido, tarjetas sintonizadoras de televisión y grabadora de DVD externa, discos duros externos y disquetera externas. Su éxito ha sido total, habiendo desplazado a conectores como el puerto serie, puerto paralelo, puerto de juegos, Apple Desktop Bus o PS/2 a mercados-nicho o a la consideración de dispositivos obsoletos a eliminar de los modernos ordenadores, pues muchos de ellos pueden sustituirse por dispositivos USB que implementen esos conectores.

Su campo de aplicación se extiende en la actualidad a cualquier dispositivo electrónico o con componentes, desde los automóviles (las radios de automóvil modernas van convirtiéndose en reproductores multimedia con conector USB o iPod) a los reproductores de Blu-ray Disc o los modernos juguetes como Pleo. Se han implementado variaciones para su uso industrial e incluso militar. Pero en donde más se nota su influencia es en los teléfonos inteligentes (Europa ha creado una norma por la que todos los móviles deberán venir con un cargador microUSB), tabletas, PDAs yvideoconsolas, donde ha reemplazado a conectores propietarios casi por completo.

Desde 2004 , aproximadamente 6 mil millones de dispositivos se encuentran actualmente en el mercado global, y alrededor de 2 mil millones se venden cada año.

Algunos dispositivos requieren una potencia mínima, así que se pueden conectar varios sin necesitar fuentes de alimentación extra. Para ello existen concentradores (llamados USB hubs) que incluyen fuentes de alimentación para aportar energía a los dispositivos conectados a ellos, pero algunos dispositivos consumen tanta energía que necesitan su propia fuente de alimentación. Los concentradores con fuente de alimentación pueden proporcionarle corriente eléctrica a otros dispositivos sin quitarle corriente al resto de la conexión (dentro de ciertos límites).

En el caso de los discos duros, sólo una selecta minoría implementan directamente la interfaz USB como conexión nativa, siendo los discos externos mayoritariamente IDE o Serial ATA con un adaptador en su interior. Incluso existen cajas externas y cunas que implementan conectores eSATAy USB, incluso USB 3.0. Estas y las mixtas USB/FireWire han expulsado del mercado de discos externos a SCSI y las conexiones por puerto paralelo.

¿Que es un sistema operativo?

Un Sistema Operativo (SO) es el software básico de una computadora que provee una interfaz entre el resto de programas del ordenador, los dispositivos hardware y el usuario.

Las funciones básicas del Sistema Operativo son administrar los recursos de la máquina, coordinar el hardware y organizar archivos y directorios en dispositivos de almacenamiento.

Uno de los propósitos del sistema operativo que gestiona el núcleo intermediario consiste en gestionar los recursos de localización y protección de acceso del hardware, hecho que alivia a los programadores de aplicaciones de tener que tratar con estos detalles. La mayoría de aparatos electrónicos que utilizan microprocesadores para funcionar, llevan incorporado un sistema operativo (teléfonos móviles, reproductores de DVD, computadoras, radios, enrutadores, etc.). En cuyo caso, son manejados mediante una Interfaz Gráfica de Usuario, un gestor de ventanas o un entorno de escritorio, si es un celular, mediante una consola o control remoto si es un DVD y, mediante una línea de comandos o navegador web si es un enrutador.

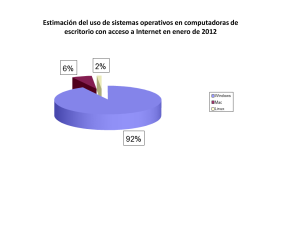

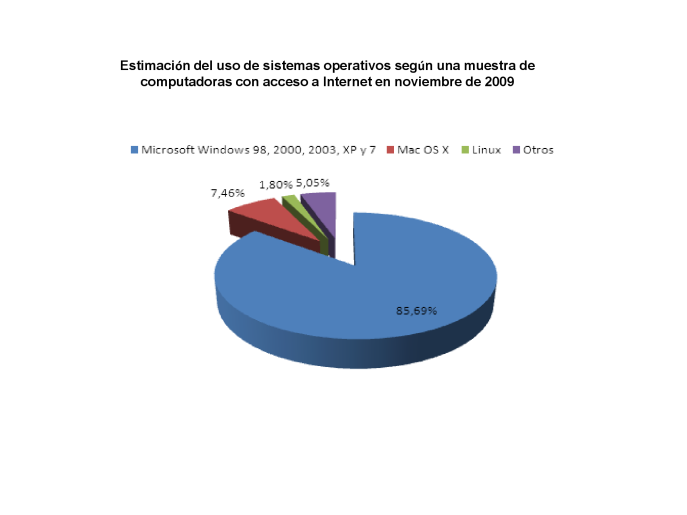

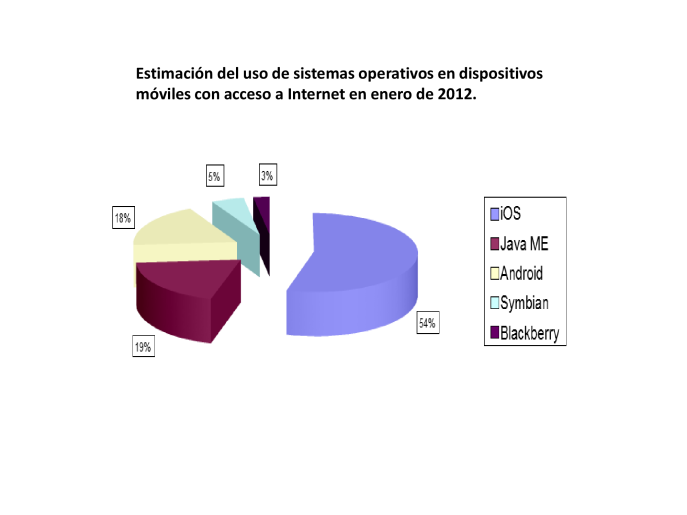

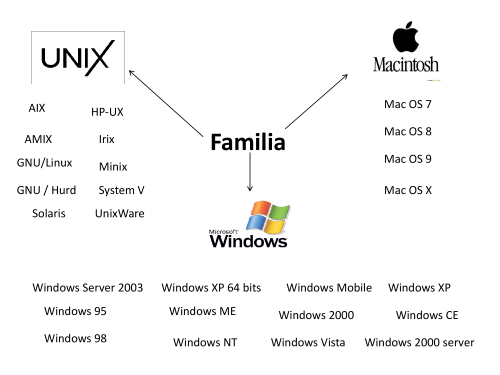

Los Sistemas Operativos más utilizados son Dos, Windows, Linux y Mac. Algunos SO ya vienen con un navegador integrado, como Windows que trae el navegador Internet Explorer.

Clasificación de los Sistemas Operativos

Los sistemas operativos pueden ser clasificados de la siguiente forma:

- Multiusuario: Permite que dos o más usuarios utilicen sus programas al mismo tiempo. Algunos sistemas operativos permiten a centenares o millares de usuarios al mismo tiempo.

- Multiprocesador: soporta el abrir un mismo programa en más de una CPU.

- Multitarea: Permite que varios programas se ejecuten al mismo tiempo.

- Multitramo: Permite que diversas partes de un solo programa funcionen al mismo tiempo.

- Tiempo Real: Responde a las entradas inmediatamente. Los sistemas operativos como DOS y UNIX, no funcionan en tiempo real.

¿Cómo funciona un Sistema Operativo?

Los sistemas operativos proporcionan una plataforma de software encima de la cual otros programas, llamados aplicaciones, puedan funcionar. Las aplicaciones se programan para que funcionen encima de un sistema operativo particular, por tanto, la elección del sistema operativo determina en gran medida las aplicaciones que puedes utilizar.

Ejemplos de Sistema Operativo

A continuación detallamos algunos ejemplos de sistemas operativos:

Software utilitario

Un utilitario es aquel software que están diseñados para realizar una tarea determinada, por ejemplo, un editor, un depurador de código o un programa recuperador de datos perdidos o borrados accidentalmente.

Se refiere al software que nos ayuda a resolver problemas relacionados con la administración de una computadora.

Hay varios tipos de software entre los cuales están:

LOS ANTIVIRUS: su función es detectar y eliminar virus informáticos. Nacieron en la década de 1980.

Con el transcurso del tiempo, la aparición de los sistemas operativos o S.O más avanzados Internet, ha hecho que los antivirus evolucionen hacia programas más avanzados que no solo buscan detectar virus informáticos, sino bloquearlos, des infectarlos y prevenir una infección de los mismos. los últimos antivirus pueden detectar otros tipos de malware como el spyware, el rootkits entre otros.

1. Norton Antivirus 2004

Norton Antivirus es la última herramienta de Symantec para protegerse de todo tipo de virus, applets Java, controles ActiveX y códigos maliciosos. Como la mayoría de los antivirus, el programa de Symantec protege la computadora mientras navega por Internet, obtiene información de disquetes, CD o de una red y comprueba los archivos adjuntos que se reciben por email. Descargar.

2. McAfeeVirus can 7

McAfee VirusScan es una de las herramientas de seguridad más conocida por los usuarios de todo el mundo. Esta nueva versión protege a la PC de posibles infecciones a través del correo electrónico, de archivos descargados desde Internet y de ataques a partir de applets de java y controles ActiveX.

3. F-Secure Antivirus 5.40

F-Secure contiene dos de los motores de búsquedas de virus más conocidos para Windows: F-PROT y AVP. Se actualiza todos los días e incluye todo lo necesario para proteger la PC contra los virus. Esta versión incluye un buscador que funciona en segundo plano, buscadores basados en reglas para detectar virus desconocidos y muchas opciones más para automatizar la detección de virus.Descargar.

4. Trend PC-Cillin 2003

El PC-cillin es un potente y conocido antivirus que realiza automáticamente búsquedas de virus basado en sus acciones y no en el código con el que fueron creados. La versión de prueba caduca a los 30 días de uso. Descargar.

5. Panda Antivirus Titanium 2.04.04

Titanium incorpora un nuevo motor hasta un 30 por ciento más rápido que sus antecesores, con un alto nivel de protección y un sistema heurístico avanzado para detectar posibles nuevos virus todavía desconocidos. Trae la tecnología SmartClean, que se encarga de reparar los daños que en el sistema provocan algunos virus. Se actualiza automáticamente.

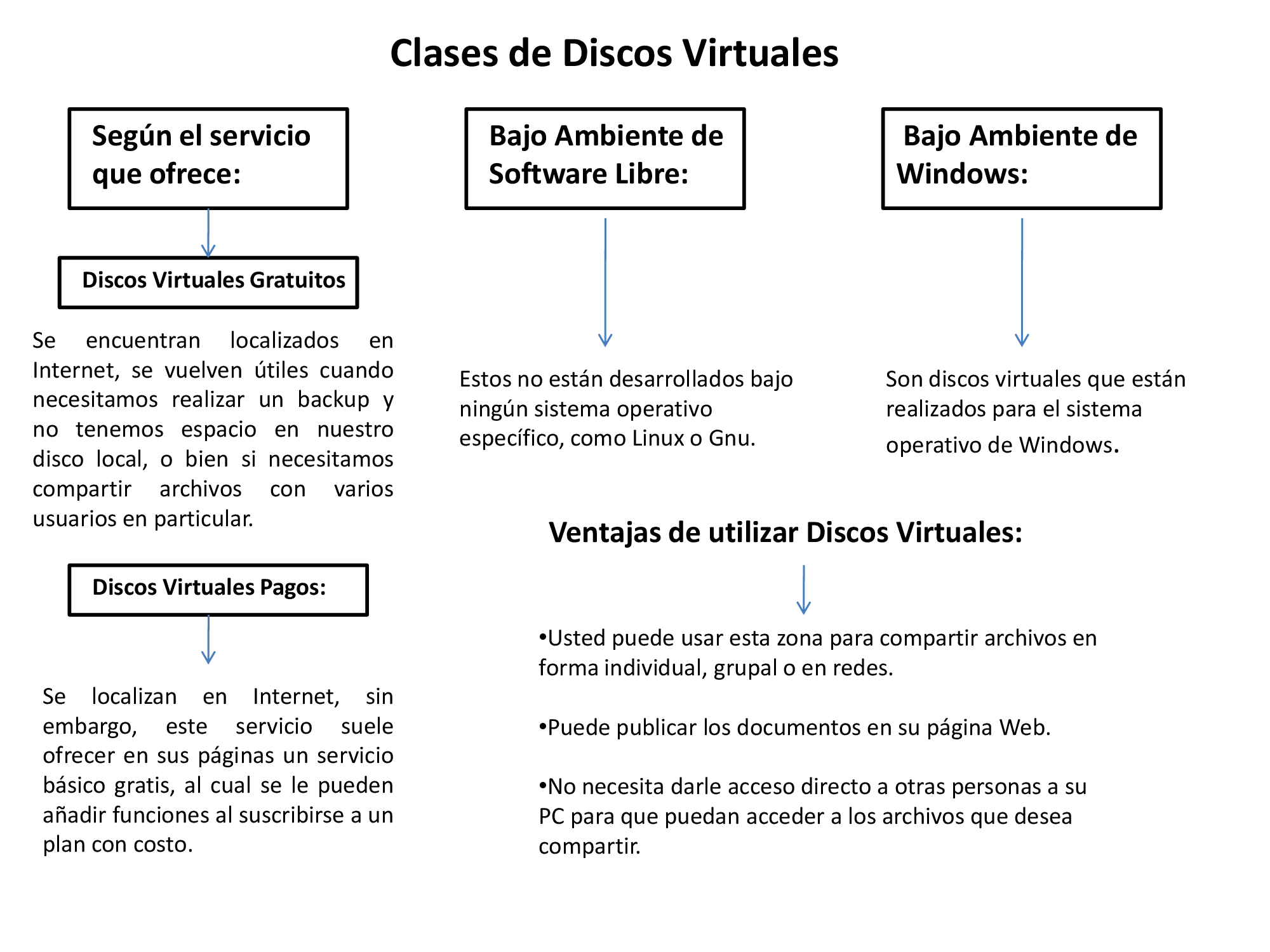

Discos Virtuales

Existen diferentes tipos de discos virtuales, dependiendo qué emulan. Por ejemplo, se puede simular un disco duro usando como medio de almacenamiento la memoria RAM, obteniéndose así un disco ultrarrápido. También se puede simular un disco duro empleando un servicio de almacenamiento online. Por ejemplo, emplear una cuenta de Gmail (que ofrece varios GB de almacenamiento), como sise tratara de un disco duro local.

Podemos encontrar varias clases de Discos Virtuales, a continuación encontramos los tipos de Discos según el servicio que ofrecen o según el software que manejan:

Compresor de archivos: Mejor aprovechamiento del espacio de almacenamiento disponible, reduciendo el que ocupa cada archivo.

Defragmentador: Mayor eficiencia en el uso del espacio de almacenamiento disponible y en el proceso de búsqueda, guardando la totalidad de cada archivo en ocupaciones contiguas.

Software para respaldo: Garantía de la disponibilidad de los datos, haciendo copias de ellos.

Software de recuperación: Restablecer archivos borrados por error.

FUENTES

http://es.wikipedia.org/wiki/Sistema_operativo

http://www.masadelante.com/faqs/sistema-operativo

http://ednahernandezzaleta.blogspot.com/2012/01/ejemplos-de-antivirus.html

http://discosvirtualesuniminuto.blogspot.com/

http://es.wikipedia.org/wiki/Disco_virtual

http://funcionesdeunsoftwareutilitario.blogspot.com/2012/02/un-utilitario-es-aquel-software-que.html

http://domingo-simon.blogspot.com/2008/10/software-utilitarios.html